Con l'esplosione dei dati su Internet, la necessità di raccogliere, elaborare e analizzare le informazioni online è diventata più importante che mai. È qui che entrano in gioco due tecniche potenti.crawling del web e scraping del web. Sebbene questi termini siano spesso usati in modo intercambiabile, non sono la stessa cosa. Se state raccogliendo i prezzi dei prodotti, monitorando i siti web dei concorrenti o costruendo un indice di ricerca, questi metodi possono aiutarvi ad automatizzare la raccolta dei dati su scala.

Lo stesso? I diversi termini per la raccolta di dati sul Web

Che cos'è il Web Crawling?

Il crawling del Web è il processo di navigazione automatica in Internet e di scoperta di URL o link in più pagine. È il modo in cui i motori di ricerca come Google trovano e indicizzano nuove pagine web.

🕷 Esempio:

Un web crawler, noto anche come spider o bot, parte da una pagina web e segue tutti i link interni/esterni per scoprire altre pagine. Ciò gli consente di raccogliere URL, ma non necessariamente di scaricare o estrarre dati specifici.

Casi d'uso tipici:

- Costruire l'indice di un motore di ricerca

- Monitoraggio delle modifiche del sito web su scala

- Rilevare i link non funzionanti sul proprio sito

Che cos'è il Web Scraping?

Scraping del web è il processo di estrazione di dati specifici da una o più pagine web. Anziché limitarsi a scoprire i link, gli scrapers si rivolgono a contenuti come nomi di prodotti, prezzi o informazioni di contatto e li formattano in CSV, JSON, ecc.

🧲 Esempio:

Potreste recuperare i prezzi dei prodotti da Walmart o altro sito di e-commerce, annunci di lavoro da un portale di carriera, statistiche sui post dei social media e così via.

Casi d'uso tipici:

- Strumenti di confronto dei prezzi

- Generazione di contatti (raccolta di contatti da elenchi)

- Ricerche di mercato (raccolta di recensioni e valutazioni)

Web Crawling Vs. Scraping del Web: Differenze principali

Mentre i crawler mappano il web, gli scrapers si concentrano sulle informazioni che contano.

| Aspetto | Crawling del web | Scraping del web |

|---|---|---|

| Obiettivo primario | Scoprire e indicizzare le pagine web | Estrarre i dati strutturati |

| Operazione | Segue i collegamenti in modo ricorsivo | Analizza ed estrae dati specifici |

| Uscita | Elenco delle pagine web | Dati strutturati (CSV, JSON, ecc.) |

| Complessità | Logica per pagina più semplice, ma la scala è importante | Logica di parsing complessa per pagina |

| Strumenti e biblioteche | Scrapy (Crawler), Heritrix, Apache Nutch, Requests, ecc. | BeautifulSoup, Selenium, lxml, Requests, ecc. |

| Obiettivo | Siti web interi | Singole pagine o elementi di pagina |

| Esempio di utilizzo | Google indicizza gli articoli di notizie | Ottenere titoli e autori degli articoli |

In molti casi, le due tecniche vengono utilizzate insieme. Un crawler trova le pagine e uno scraper ne estrae i dati.

Snippet di codice Python: Crawling del web vs. Scraping Scraping

Vediamo alcuni frammenti minimi di codice Python per il crawling e lo scraping.

Come eseguire il crawling del Web in Python

Python semplifica il crawling del web con librerie come Scarti o Richieste + Bella Zuppa.

Esempio: Semplice crawler web con Scrapy

# installare: pip installare scrapy

importare scrapy

classe SimpleCrawler(scrapy.Spider):

name = "simple_crawler"

start_urls = ["https://example.com"]

def parse(self, response):

# Stampa il titolo della pagina

title = response.css('title::text').get()

yield {'url': response.url, 'title': title}

# Seguire tutti i collegamenti interni

for href in response.css('a::attr(href)').getall():

if href.startswith('/'):

yield response.follow(href, callback=self.parse)Esempio: Un semplice crawler web che utilizza Requests + BeautifulSoup

importare le richieste

da bs4 import BeautifulSoup

da urllib.parse import urljoin

visitato = set()

start_url = "https://example.com"

def crawl(url):

se url in visited:

return

visitato.add(url)

try:

response = requests.get(url)

soup = BeautifulSoup(response.text, 'html.parser')

print("Crawling:", url)

per link in soup.find_all('a', href=True):

full_url = urljoin(url, link['href'])

crawl(full_url)

tranne Exception as e:

print("Fallito il crawl:", url, "Motivo:", e)

crawl(start_url) Nota: Il crawling rapido di siti web di grandi dimensioni può far sì che il vostro IP venga segnalato e bloccato. Per questo motivo è necessario Proxy IP a rotazione.

Come fare Web Scarping in Python

Il web scraping in Python consiste nell'estrarre dati da siti web utilizzando script automatici. Una delle librerie più popolari per questo compito è Bella Zuppa, spesso utilizzato in combinazione con Richieste.

Ad esempio, è possibile individuare tag, attributi o classi specifiche ed estrarre informazioni utili come nomi di prodotti, prezzi o titoli.

Esempio: Scraping dei titoli dei prodotti da una pagina

importare le richieste

da bs4 import BeautifulSoup

url = "https://example.com/products"

resp = requests.get(url)

soup = BeautifulSoup(resp.text, 'html.parser')

per prodotto in soup.select(".product"):

name = product.select_one(".name").get_text(strip=True)

prezzo = prodotto.select_one(".prezzo").get_text(strip=True)

print({"nome": nome, "prezzo": prezzo})Si possono usare selettori o XPath per prelevare dati da tabelle, elenchi o elementi HTML personalizzati.

Suggerimento: Sebbene il web scraping e il crawling siano comunemente legali, alcuni siti web vietano tale comportamento nei termini di servizio o nei loro robots.txt file. Controllate sempre quali sono i percorsi consentiti o non consentiti per il vostro bot.

Rimanere sbloccati senza divieto IP utilizzando IP Proxy

L'esecuzione di molte richieste dal vostro indirizzo IP può innescare difese anti-bot come i CAPTCHA o veri e propri divieti dai siti web. Per mantenere l'affidabilità e la velocità, considerate l'utilizzo di un proxy IP, che può passare automaticamente tra milioni di indirizzi IP reali.

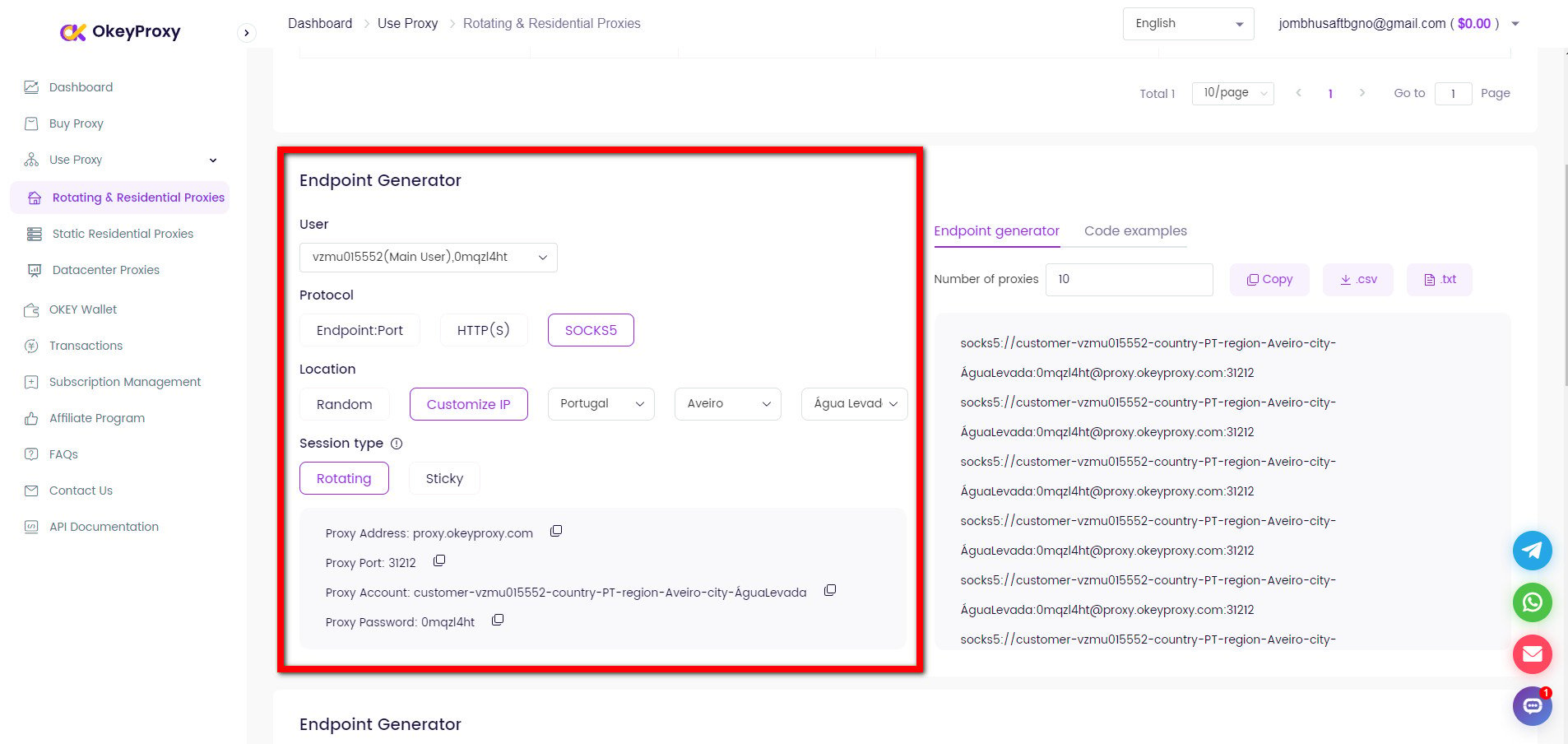

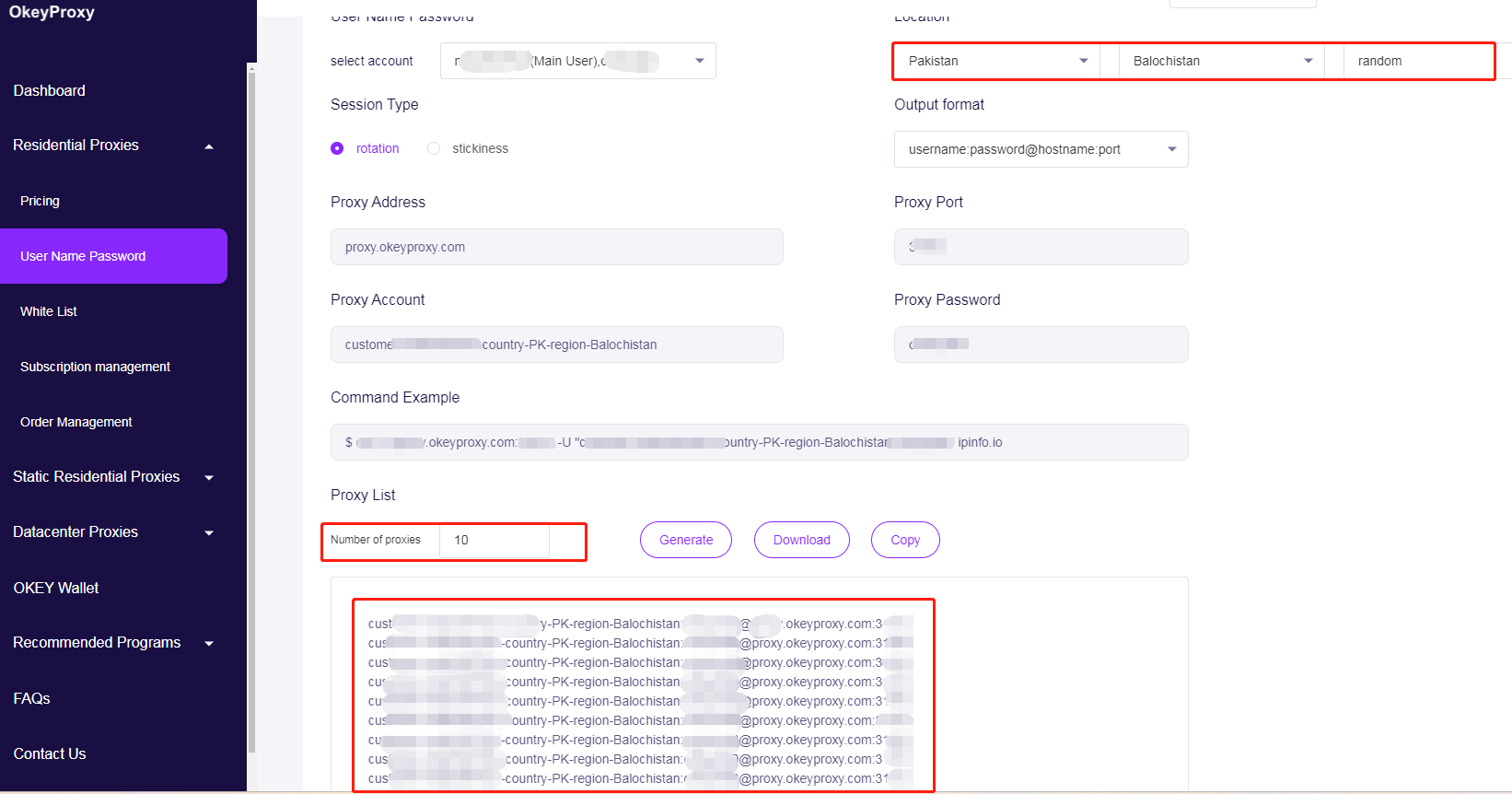

È sufficiente configurare il client HTTP per utilizzare OkeyProxy con un nuovo indirizzo IP o con la rotazione degli indirizzi IP:

Passaggio a nuovi IP per evitare i limiti di web crawling/scraping

proxy = {

"http": "http://username:[email protected]:1234",

"https": "http://username:[email protected]:1234",

}

resp = requests.get(url, headers=intestazioni, proxies=proxies, timeout=10)Ruotare gli IP dei proxy per evitare i limiti di crawling/scraping del web

# Pool proxy - sostituire con i propri IP proxy

PROXY_POOL = [

"http://username1:[email protected]:1234",

"http://username2:[email protected]:1234",

"http://username3:[email protected]:1234",

"http://username4:[email protected]:1234"

]

# Seleziona e convalida in modo casuale un proxy dal pool

def rotate_proxy():

mentre True:

proxy = random.choice(PROXY_POOL)

se check_proxy(proxy):

restituisce il proxy

altrimenti:

print(f "Il proxy {proxy} non è disponibile, provarne un altro...")

PROXY_POOL.remove(proxy)

raise Exception("Non ci sono più proxy validi nel pool.")

# Verificare se un proxy funziona facendo una richiesta di prova

def check_proxy(proxy):

try:

test_url = "https://httpbin.org/ip"

response = requests.get(test_url, proxies={"http": proxy}, timeout=10)

return response.status_code == 200

except:

return FalseCon un servizio di delega residenziale di alta qualitàÈ possibile eseguire in modo sicuro web crawler o scrapers in scala senza preoccuparsi di divieti o rifiuti.

A cosa servono il crawling e lo scraping dei dati?

Ampiamente utilizzati per estrarre informazioni preziose dalle vaste quantità di dati disponibili online, il web crawling e il web scraping sono diventati strumenti indispensabili alla base dell'odierna economia dei dati.

Da un lato, le organizzazioni sfruttano il web scraping per raccogliere le recensioni dei clienti, i post dei forum e le conversazioni sui social media per l'analisi del sentiment. Oltre all'analisi del sentiment dei consumatori, il crawling dei dati alimenta le piattaforme di market intelligence, che il mercato dei dati alternativi, che include il web scraping, è stato valutato a 4,9 miliardi di dollari nel 2023 e si prevede che crescerà a un tasso di tasso annuo di 28% fino al 2032. In effetti, nel 2024 il 42,0% dei budget per i dati aziendali sarà destinato specificamente all'acquisizione e all'elaborazione dei dati web, sottolineando il ruolo critico che questi ultimi rivestono nel processo di sviluppo di un'impresa. processo decisionale basato sui dati. Nel settore della vendita al dettaglio, il 59% dei rivenditori utilizza strumenti di monitoraggio dei prezzi competitivi, spesso basati su scraping automatizzato, per ottimizzare le strategie di prezzo dinamico e incrementare i ricavi.

D'altro canto, una delle applicazioni principali del crawling e dello scraping dei dati è l'alimentazione di IA e apprendimento automatico con il 65,0% delle organizzazioni che sfruttano il web scraping per alimentare i loro modelli. Ad esempio, l'archivio di Common Crawl dell'aprile 2024 ha raccolto 2,7 miliardi di pagine web (386 TiB di contenuti), fungendo da set di dati fondamentali per l'addestramento dei principali modelli NLP. Inoltre, anche i ricercatori accademici e le piattaforme come Semantic Scholar, che hanno indicizzato oltre 205 milioni di documenti accademici, hanno utilizzato i web crawler per indicizzare vasti volumi di letteratura. I team SEO e di marketing utilizzano i web crawler per le verifiche dei siti, l'analisi dei backlink e la ricerca sulla concorrenza.

Conclusione

Il web crawling consiste nello scoprire e visitare pagine; il web scraping consiste nell'estrarre dati. Python rende queste due tecniche accessibili anche ai non sviluppatori.

Combinando il crawling responsabile, lo scraping mirato e la gestione affidabile per proxy di scraping e crawlingÈ possibile creare potenti pipeline di dati che alimentano le analisi, i modelli di apprendimento automatico e le intuizioni aziendali, senza interruzioni.

Siete pronti a potenziare il vostro web crawling e web scraping? Iniziate con un prova di OkeyProxy oggi stesso e sperimentate una raccolta di dati su larga scala senza soluzione di continuità!

Servizio proxy Socks5/Http di prim'ordine

- Piani scalabili: Statico/Proxy residenziali a rotazione

- Integrazione perfetta: Win/iOS/Android/Linux

- Alta sicurezza: Ideale per i browser anti-rilevamento, gli emulatori, gli scrapers, ecc.

- Prestazioni affidabili: Trasferimento rapido e bassa latenza