Con la explosión de datos en Internet, la necesidad de recopilar, procesar y analizar la información en línea se ha vuelto más importante que nunca. Ahí es donde entran en juego dos potentes técnicas.rastreo web y raspado web. Aunque estos términos suelen utilizarse indistintamente, no son lo mismo. Ya se trate de recopilar precios de productos, supervisar sitios web de la competencia o crear un índice de búsqueda, estos métodos pueden ayudarle a automatizar la recopilación de datos a escala.

¿Igual? Diferentes términos para la recogida de datos en la web

¿Qué es el rastreo web?

El rastreo web es el proceso de navegar automáticamente por Internet y descubrir URL o enlaces en varias páginas. Es la forma en que los motores de búsqueda como Google encuentran e indexan nuevas páginas web.

🕷 Ejemplo:

Un rastreador web, también conocido como araña o bot, parte de una página web y sigue todos los enlaces internos/externos para descubrir más páginas. Esto le permite recopilar URL, pero no necesariamente descargar o extraer datos específicos.

Casos de uso típicos:

- Creación de un índice de motores de búsqueda

- Control de los cambios del sitio web a escala

- Detección de enlaces rotos en su propio sitio

¿Qué es el Web Scraping?

Web scraping es el proceso de extraer datos específicos de una o varias páginas web. En lugar de limitarse a descubrir enlaces, los scrapers se centran en contenidos como nombres de productos, precios o información de contacto y los formatean en CSV, JSONetc.

🧲 Ejemplo:

Puede que raspar los precios de los productos de Walmart u otro sitio de comercio electrónico, ofertas de empleo de un portal de empleo, estadísticas de publicaciones en redes sociales, etc.

Casos de uso típicos:

- Herramientas de comparación de precios

- Generación de contactos (recopilación de contactos de directorios)

- Estudios de mercado (recopilación de opiniones y valoraciones)

Web Crawling Vs. Web Scraping: Principales diferencias

Mientras que los rastreadores cartografían la web, los raspadores se centran en la información que importa.

| Aspecto | Rastreo web | Raspado web |

|---|---|---|

| Objetivo principal | Descubrir e indexar páginas web | Extraer datos estructurados |

| Operación | Sigue los enlaces de forma recursiva | Analiza y extrae datos específicos |

| Salida | Lista de páginas web | Datos estructurados (CSV, JSON, etc.) |

| Complejidad | Lógica por página más sencilla, pero la escala importa | Lógica compleja de análisis sintáctico por página |

| Herramientas y bibliotecas | Scrapy (Crawler), Heritrix, Apache Nutch, Requests, etc. | BeautifulSoup, Selenium, lxml, Requests, etc. |

| Objetivo | Sitios web completos | Páginas individuales o elementos de página |

| Ejemplo de uso | Google indexa artículos de noticias | Obtener títulos y autores de artículos |

En muchos casos, ambas técnicas se utilizan conjuntamente. Un crawler encuentra páginas y un scraper extrae los datos de ellas.

Fragmentos de código Python: Web Crawling Vs. Scraping

Veamos fragmentos mínimos de código Python para crawling y scraping.

Cómo hacer rastreo web en Python

Python facilita el rastreo web con bibliotecas como Chatarra o Solicitudes + BeautifulSoup.

Ejemplo: Rastreador web simple con Scrapy

# install: pip install scrapy

importar scrapy

clase SimpleCrawler(scrapy.Spider):

name = "simple_crawler"

start_urls = ["https://example.com"]

def parse(self, response):

# Imprime el título de la página

title = response.css('title::text').get()

yield {'url': response.url, 'title': title}

# Sigue todos los enlaces internos

for href in response.css('a::attr(href)').getall():

if href.startswith('/'):

yield response.follow(href, callback=self.parse)Ejemplo: Simple Web Crawler usando Requests + BeautifulSoup

importar peticiones

from bs4 import BeautifulSoup

from urllib.parse import urljoin

visitado = set()

url_inicial = "https://example.com"

def rastrear(url):

if url in visited:

return

visited.add(url)

intentar:

response = requests.get(url)

soup = BeautifulSoup(response.text, 'html.parser')

print("Rastreando:", url)

for link in soup.find_all('a', href=True):

full_url = urljoin(url, link['href'])

crawl(full_url)

except Exception as e:

print("Fallo al rastrear:", url, "Razón:", e)

rastrear(url_inicial) Nota: Rastrear grandes sitios web rápidamente puede hacer que su IP sea marcada y bloqueada. Por eso necesitas proxies IP rotativos.

Cómo hacer Web Scarping en Python

El web scraping en Python consiste en extraer datos de sitios web mediante scripts automatizados. Una de las bibliotecas más populares para esta tarea es BeautifulSoupa menudo se utiliza en combinación con Solicitudes.

Por ejemplo, puede localizar tag, atributos o clases específicos y extraer información útil como nombres de productos, precios o titulares.

Ejemplo: Extracción de títulos de productos de una página

importar peticiones

from bs4 import BeautifulSoup

url = "https://example.com/products"

resp = requests.get(url)

soup = BeautifulSoup(resp.text, 'html.parser')

for producto in soup.select(".producto"):

name = product.select_one(".name").get_text(strip=True)

precio = product.select_one(".precio").get_text(strip=True)

print({"nombre": nombre, "precio": precio})Puede utilizar selectores o XPath para obtener datos de tablas, listados o elementos HTML personalizados.

Consejo: Aunque el web scraping y el crawling suelen ser legales, algunos sitios web prohíben este comportamiento en sus condiciones de servicio o en sus robots.txt archivos. Comprueba siempre qué rutas están permitidas o no para tu bot.

Permanecer desbloqueado sin IP Ban Usando IP Proxy

Realizar muchas peticiones desde tu dirección IP puede activar defensas anti-bot como CAPTCHAs o directamente prohibir el acceso a sitios web. Para mantener la fiabilidad y la velocidad, considera añadir el uso de un proxy IP, que puede cambiar automáticamente entre millones de direcciones IP reales.

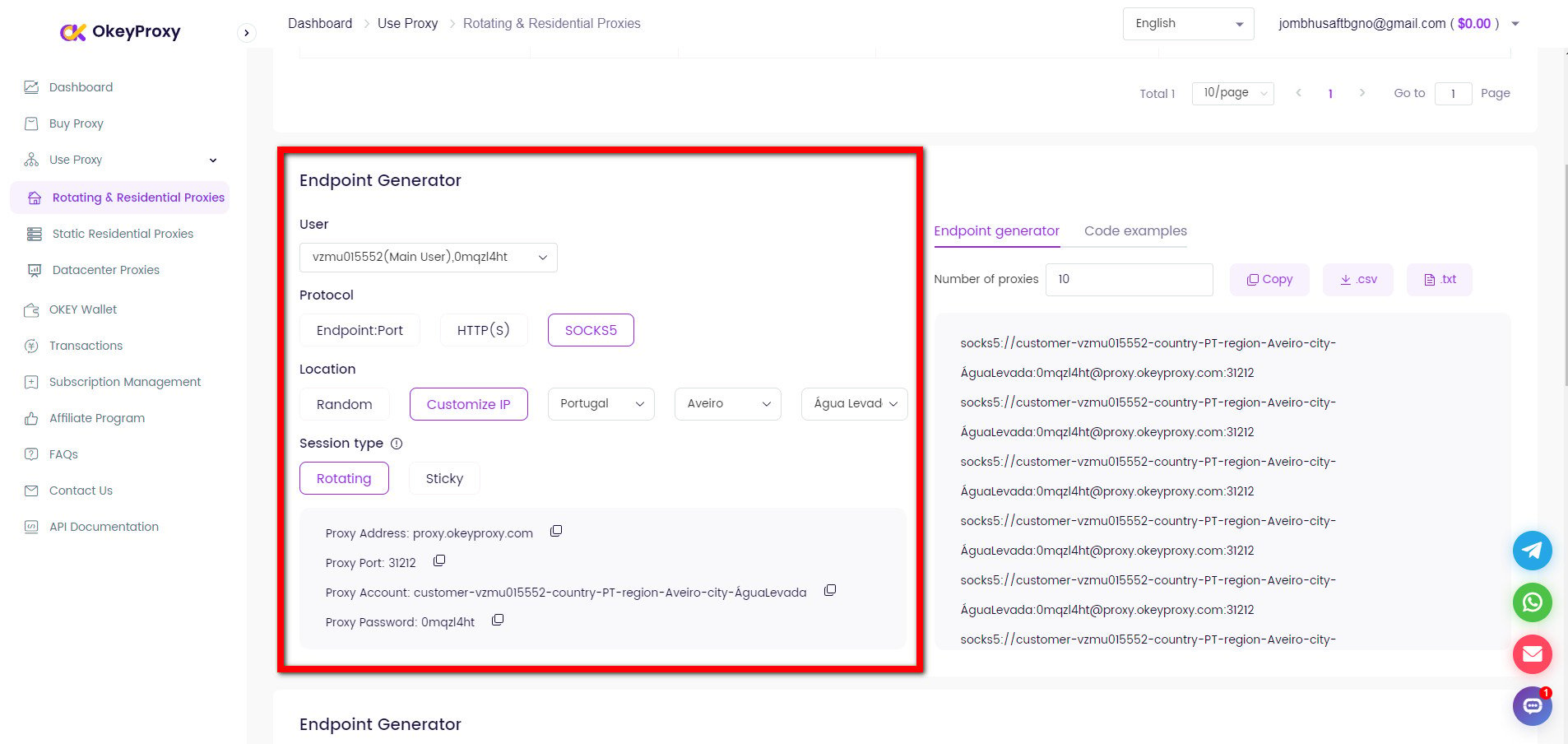

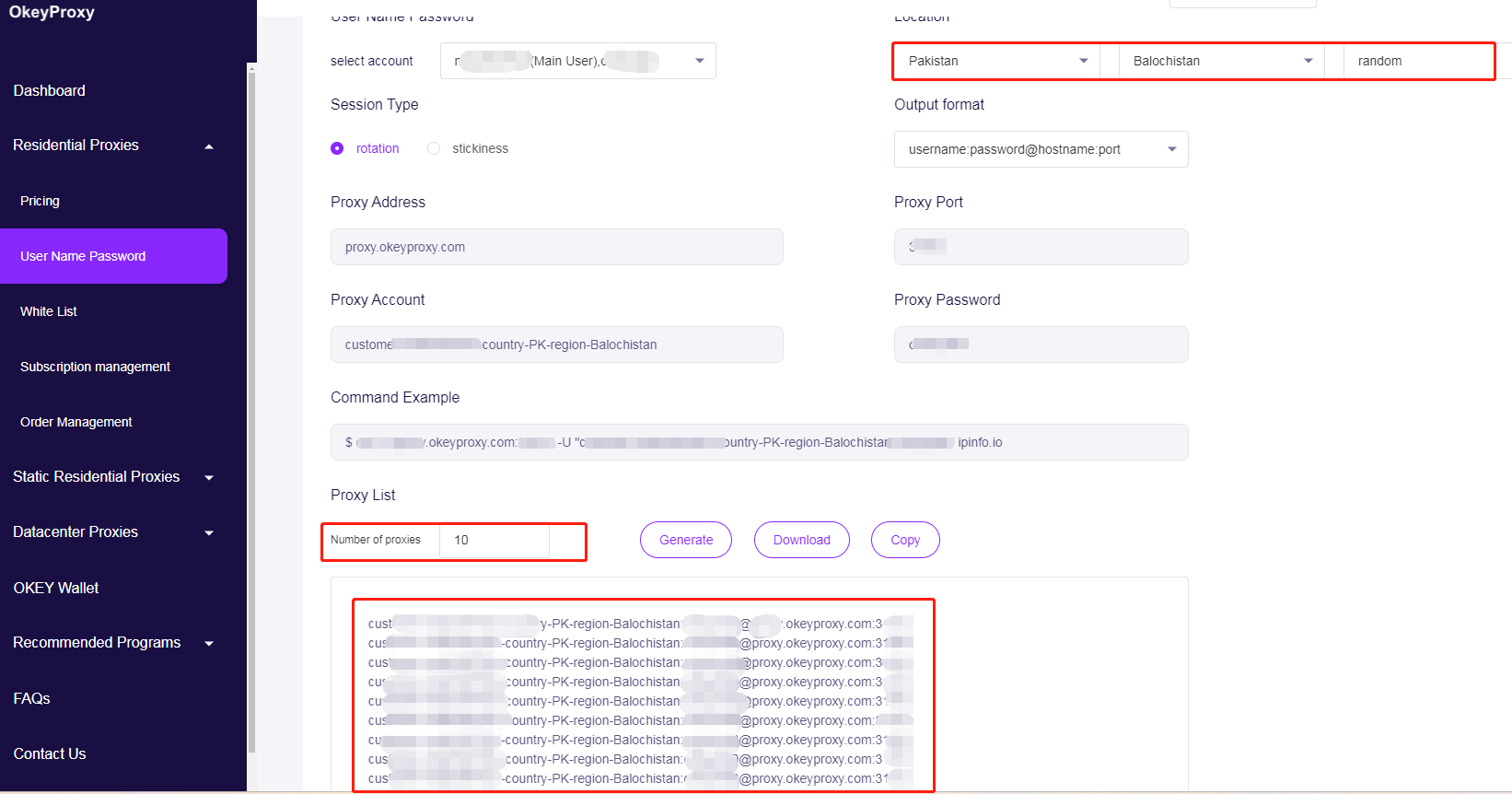

Basta con configurar el cliente HTTP para que utilice OkeyProxy con una nueva dirección IP o rotando las direcciones IP:

Cambio a nuevas IP para evitar los límites de rastreo y scraping web

proxies = {

"http": "http://username:[email protected]:1234",

"https": "http://username:[email protected]:1234",

}

resp = requests.get(url, headers=cabeceras, proxies=proxies, timeout=10)Rotación de IPs proxy para evitar los límites de rastreo y scraping web

# Proxy pool - reemplace con sus IPs proxy

PROXY_POOL = [

"http://username1:[email protected]:1234",

"http://username2:[email protected]:1234",

"http://username3:[email protected]:1234",

"http://username4:[email protected]:1234"

]

# Seleccionar y validar aleatoriamente un proxy del pool

def rotar_proxy():

while True:

proxy = random.choice(PROXY_POOL)

if check_proxy(proxy):

return proxy

else:

print(f "Proxy {proxy} no está disponible, pruebe con otro...")

PROXY_POOL.remove(proxy)

raise Exception("No quedan proxies válidos en el pool.")

# Comprueba si un proxy funciona haciendo una petición de prueba

def comprobar_proxy(proxy):

try:

test_url = "https://httpbin.org/ip"

response = requests.get(test_url, proxies={"http": proxy}, timeout=10)

return response.status_code == 200

except:

return FalseCon un servicio de proxy residencial de alta calidadpuede ejecutar de forma segura rastreadores web o scrapers a escala sin preocuparse por prohibiciones o rechazos.

¿Para qué se utilizan el rastreo de datos y el scraping?

Ampliamente utilizados para extraer información valiosa de las enormes cantidades de datos disponibles en línea, el rastreo y el scraping web se han convertido en herramientas indispensables para la economía de datos actual.

Por un lado, las organizaciones aprovechan el web scraping para recopilar opiniones de clientes, publicaciones en foros y conversaciones en redes sociales para el análisis de sentimientos. Más allá del análisis de los sentimientos de los consumidores, el rastreo de datos impulsa las plataformas de inteligencia de mercado, que el mercado de datos alternativos, que incluye el web scraping, se valoró en 4 900 millones de USD en 2023 y se prevé que crezca a un ritmo de 1 000 millones de USD en los próximos años. tasa anual de 28% hasta 2032. De hecho, 42,0% de los presupuestos de datos empresariales en 2024 se asignaron específicamente a la adquisición y procesamiento de datos web, lo que subraya su papel fundamental en toma de decisiones basada en datos. Y en el sector minorista, 59% de los minoristas utilizan herramientas de seguimiento de precios competitivos -a menudo basadas en scraping automatizado- para optimizar las estrategias de precios dinámicos y aumentar los ingresos.

Por otra parte, una de las principales aplicaciones del rastreo y el scraping de datos es alimentar IA y aprendizaje automático con un 65,0% de organizaciones que aprovechan el web scraping para alimentar sus modelos. Por ejemplo, el archivo de Common Crawl de abril de 2024 recopiló 2.700 millones de páginas web (386 TiB de contenido), sirviendo de conjunto de datos fundamental para el entrenamiento de los principales modelos de PLN. Además, investigadores académicos y plataformas como Semantic Scholar, que ha indexado más de 205 millones de artículos académicos, también han utilizado rastreadores web para indexar grandes volúmenes de literatura. Y los equipos de SEO y marketing emplean rastreadores web para realizar auditorías de sitios, análisis de backlinks e investigaciones sobre la competencia.

Conclusión

El rastreo web consiste en descubrir y visitar páginas; el scraping web consiste en extraer datos. Python hace que estas dos técnicas sean accesibles, incluso para los no desarrolladores.

Combinando el rastreo responsable, el scraping selectivo y la gestión fiable para proxies de raspado y rastreoCon el software de gestión de datos, puede crear potentes canalizaciones de datos que impulsen el análisis, los modelos de aprendizaje automático y la información empresarial, sin interrupciones.

¿Preparado para potenciar el rastreo y el scraping web? Empiece con un prueba de OkeyProxy hoy mismo y experimente una recogida de datos a gran escala y sin fisuras.

Servicio proxy Socks5/Http(s) de primera clase

- Planes escalables: Estático/Rotación de apoderados residenciales

- Integración perfecta: Win/iOS/Android/Linux

- Alta Seguridad: Ideal para Navegadores Antidetección, Emuladores, Scrapers, etc.

- Rendimiento fiable: Transferencia rápida y baja latencia