В связи с бурным ростом объема данных в Интернете необходимость сбора, обработки и анализа онлайн-информации стала как никогда актуальной. Именно здесь на помощь приходят две мощные технологии.просмотр веб-страниц и веб-скрепинг. Хотя эти термины часто используются как взаимозаменяемые, это не одно и то же. Независимо от того, собираете ли вы цены на товары, отслеживаете сайты конкурентов или создаете поисковый индекс, эти методы помогут вам автоматизировать сбор данных в масштабе.

То же самое? Различные термины для сбора данных в Интернете

Что такое веб-кроулинг?

Веб-ползание - это процесс автоматического просмотра Интернета и обнаружения URL-адресов или ссылок на нескольких страницах. Подумайте о том, как поисковые системы, такие как Google, находят и индексируют новые веб-страницы.

🕷 Пример:

Веб-краулер, также известный как паук или бот, начинает работу с веб-страницы и переходит по всем внутренним/внешним ссылкам, чтобы обнаружить больше страниц. Это позволяет ему собирать URL-адреса, но не обязательно загружать или извлекать конкретные данные.

Типичные примеры использования:

- Создание индекса поисковой системы

- Мониторинг изменений на сайте в масштабе

- Обнаружение неработающих ссылок на собственном сайте

Что такое веб-скраппинг?

Веб-скраппинг это процесс извлечения определенных фрагментов данных с одной или нескольких веб-страниц. Вместо того чтобы просто обнаруживать ссылки, скреперы нацеливаются на такой контент, как названия продуктов, цены или контактная информация, и оформляют его в виде CSV, JSON, и т.д.

🧲 Пример:

Вы можете выудить цены на товары из Walmart или другой сайт электронной коммерции, объявления о вакансиях с карьерного портала, статистика постов в социальных сетях и так далее.

Типичные примеры использования:

- Инструменты сравнения цен

- Генерация лидов (сбор контактов из каталогов)

- Исследование рынка (сбор отзывов, рейтингов)

Веб-краулинг и веб-скраппинг. Веб-скрапинг: Основные различия

В то время как краулеры изучают веб-страницы, скреперы отбирают самую важную информацию.

| Аспект | Поползновение в Интернете | Веб-скрепинг |

|---|---|---|

| Основная цель | Обнаружение и индексирование веб-страниц | Извлечение структурированных данных |

| Операция | Рекурсивно переходит по ссылкам | Разбор и извлечение определенных данных |

| Выход | Список веб-страниц | Структурированные данные (CSV, JSON и т. д.) |

| Сложность | Более простая логика для каждой страницы, но масштаб имеет значение | Сложная логика синтаксического анализа каждой страницы |

| Инструменты и библиотеки | Scrapy (Crawler), Heritrix, Apache Nutch, Requests и др. | BeautifulSoup, Selenium, lxml, Requests и т.д. |

| Цель | Целые сайты | Отдельные страницы или элементы страниц |

| Пример использования | Google индексирует новостные статьи | Получение названий и авторов статей |

Во многих случаях обе техники используются вместе. Краулер находит страницы, а скрапер извлекает из них данные.

Сниппеты кода Python: Web Crawling Vs. Скрапинг

Давайте рассмотрим минимальные фрагменты кода на Python для краулинга и скраппинга.

Как сделать веб-краулинг на Python

Python облегчает работу с веб-страницами с помощью таких библиотек, как Scrapy или Запросы + BeautifulSoup.

Пример: Простой веб-краулер с помощью Scrapy

Установка #: pip install scrapy

импортировать scrapy

class SimpleCrawler(scrapy.Spider):

name = "simple_crawler"

start_urls = ["https://example.com"]

def parse(self, response):

# Вывести заголовок страницы

title = response.css('title::text').get()

yield {'url': response.url, 'title': title}

# Перейдите по всем внутренним ссылкам

for href in response.css('a::attr(href)').getall():

if href.startswith('/'):

yield response.follow(href, callback=self.parse)Пример: Простой веб-краулер с использованием Requests + BeautifulSoup

импортировать запросы

from bs4 import BeautifulSoup

из urllib.parse import urljoin

visited = set()

start_url = "https://example.com"

def crawl(url):

if url in visited:

return

visited.add(url)

try:

response = requests.get(url)

soup = BeautifulSoup(response.text, 'html.parser')

print("Crawling:", url)

for link in soup.find_all('a', href=True):

full_url = urljoin(url, link['href'])

crawl(full_url)

except Exception as e:

print("Failed to crawl:", url, "Reason:", e)

crawl(start_url) Примечание: Быстрый просмотр больших сайтов может привести к тому, что ваш IP будет заблокирован. Поэтому вам необходимо вращающиеся IP-прокси.

Как сделать веб-скарификацию в Python

Веб-скраппинг в Python подразумевает извлечение данных с веб-сайтов с помощью автоматических скриптов. Одной из самых популярных библиотек для этой задачи является BeautifulSoupчасто используется в сочетании с Запросы.

Например, вы можете находить определенные tag, атрибуты или классы и извлекать из них полезную информацию, такую как названия продуктов, цены или заголовки.

Пример: Скраппинг названий продуктов со страницы

импортировать запросы

из bs4 import BeautifulSoup

url = "https://example.com/products"

resp = requests.get(url)

soup = BeautifulSoup(resp.text, 'html.parser')

for product in soup.select(".product"):

name = product.select_one(".name").get_text(strip=True)

цена = product.select_one(".price").get_text(strip=True)

print({"name": name, "price": price})Вы можете использовать селекторы или XPath для захвата данных из таблиц, списков или пользовательских элементов HTML.

Совет: Хотя веб-скраппинг и краулинг обычно являются законными, некоторые сайты запрещают такое поведение в условиях предоставления услуг или на своих сайтах. robots.txt файлы. Всегда проверяйте, какие пути разрешены или запрещены для вашего бота.

Оставаться незаблокированным без IP-бана с помощью IP-прокси

Большое количество запросов с вашего IP-адреса может привести к срабатыванию средств защиты от ботов, таких как CAPTCHA, или к полному запрету доступа к сайтам. Для поддержания надежности и скорости работы рассмотрите возможность использования IP-прокси, который может автоматически переключаться между миллионами реальных IP-адресов.

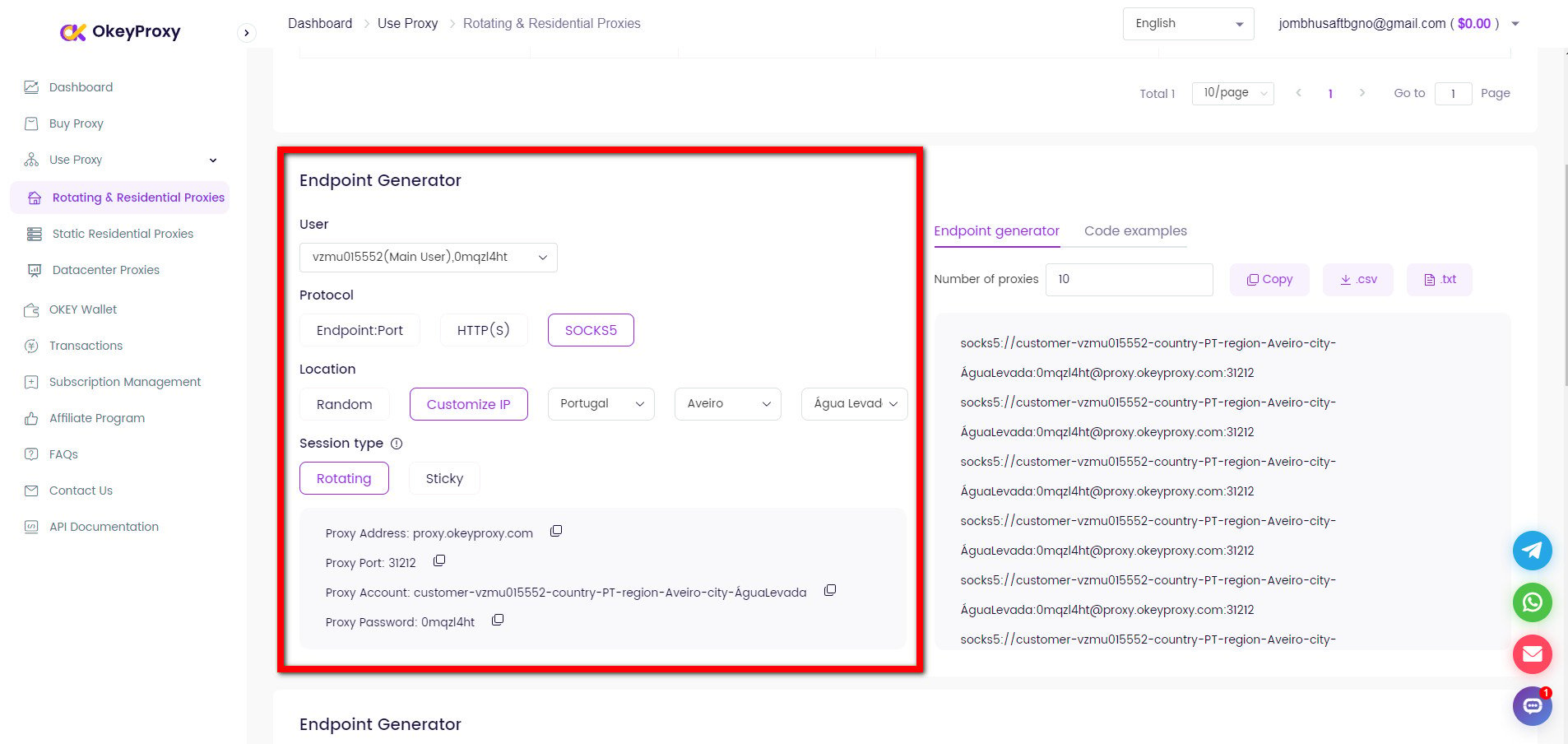

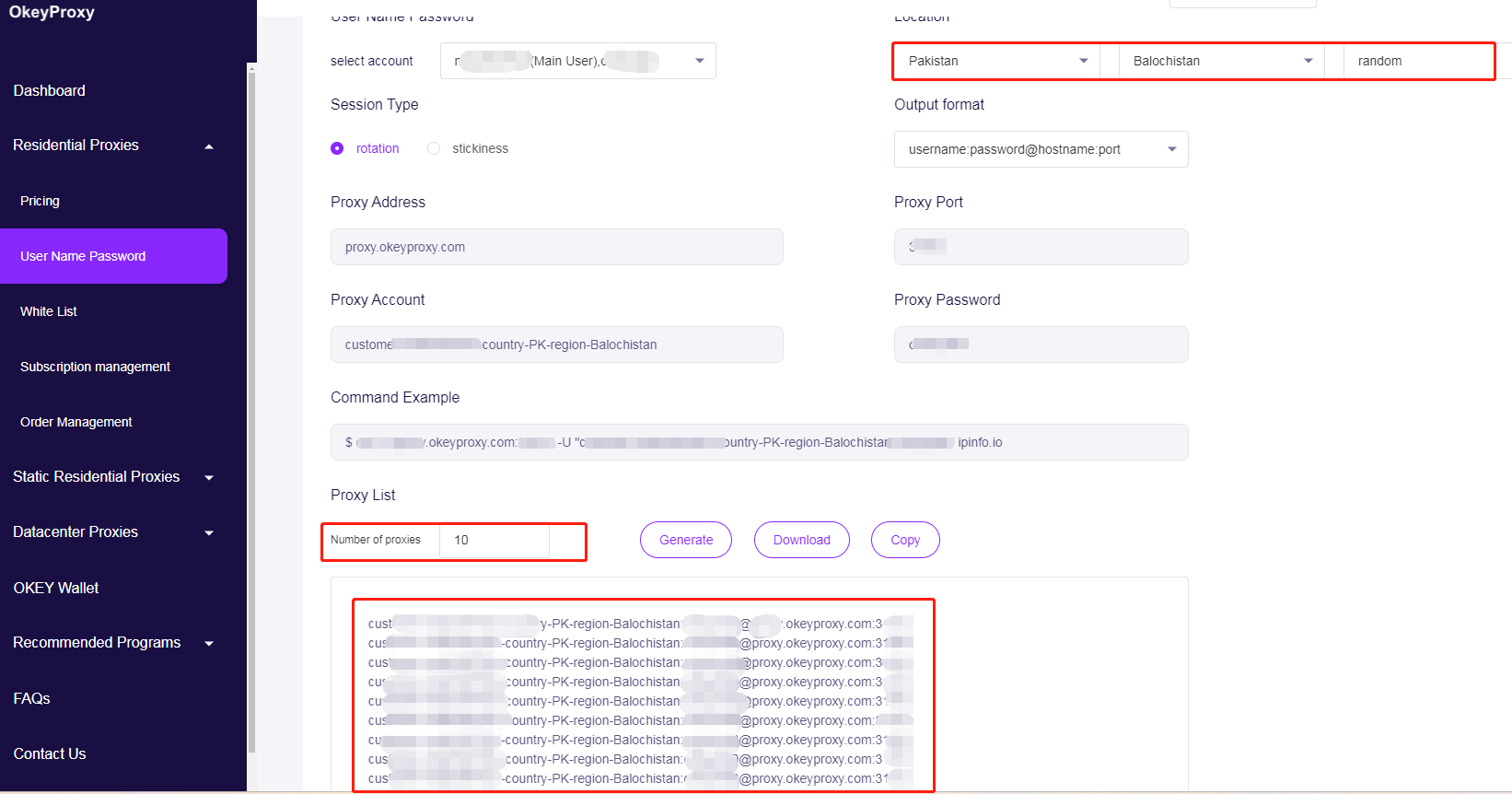

Просто настройте HTTP-клиент на использование OkeyProxy с новым IP-адресом или чередованием IP-адресов:

Переход на новые IP-адреса для обхода ограничений на веб-краулинг/скрепинг

прокси = {

"http": "http://username:[email protected]:1234",

"https": "http://username:[email protected]:1234",

}

resp = requests.get(url, headers=headers, proxies=proxies, timeout=10)Ротация IP-адресов прокси-серверов, чтобы избежать ограничений на веб-скраппинг

Пул прокси # - замените на свои IP-адреса прокси

PROXY_POOL = [

"http://username1:[email protected]:1234",

"http://username2:[email protected]:1234",

"http://username3:[email protected]:1234",

"http://username4:[email protected]:1234"

]

# Случайный выбор и проверка прокси из пула

def rotate_proxy():

while True:

proxy = random.choice(PROXY_POOL)

if check_proxy(proxy):

return proxy

else:

print(f "Прокси {proxy} недоступен, попробуем другой...")

PROXY_POOL.remove(proxy)

raise Exception("В пуле не осталось действующих прокси").

# Проверьте, работает ли прокси, сделав тестовый запрос

def check_proxy(proxy):

try:

test_url = "https://httpbin.org/ip"

response = requests.get(test_url, proxies={"http": proxy}, timeout=10)

return response.status_code == 200

кроме:

return FalseС высококачественное обслуживание по доверенности в жилых помещенияхВы можете безопасно запускать веб-краулеры или скреперы в больших масштабах, не беспокоясь о запретах или отказах.

Для чего используются краулинг и скраппинг данных?

Широко используемые для извлечения ценной информации из огромных объемов данных, доступных в Интернете, веб-скребы и веб-скраппинг стали незаменимыми инструментами, лежащими в основе современной экономики данных.

С одной стороны, организации используют веб-скрепинг для сбора отзывов клиентов, сообщений на форумах и разговоров в социальных сетях для анализа настроений. Помимо анализа потребительских настроений, сбор данных позволяет использовать платформы для анализа рынка, поэтому рынок альтернативных данных, включающий веб-скрепинг, оценивается в 4,9 млрд долларов США в 2023 году и, по прогнозам, будет расти с темпом годовая ставка 28% до 2032 года. Более того, 42,0% бюджета на корпоративные данные в 2024 году будут выделены именно на приобретение и обработку веб-данных, что подчеркивает их важнейшую роль в принятие решений на основе данных. А в секторе розничной торговли 59% ритейлеров используют инструменты мониторинга конкурентных цен, часто основанные на автоматизированном скраппинге, для оптимизации стратегий динамического ценообразования и увеличения доходов.

С другой стороны, одно из основных применений сбора и скретчинга данных - это обеспечение работы ИИ и машинное обучение 65,0% организаций используют веб-скраппинг для создания своих моделей. Например, архив Common Crawl за апрель 2024 года собрал 2,7 миллиарда веб-страниц (386 Тбайт контента), что послужило основополагающий набор данных для обучения основных моделей НЛП. Кроме того, академические исследователи и платформы, такие как Semantic Scholar, которые проиндексировали более 205 миллионов научных работ, также используют веб-краулеры для индексации огромных массивов литературы. А команды SEO и маркетологов используют веб-краулеры для аудита сайтов, анализа обратных ссылок и изучения конкурентов.

Заключение

Веб-кроулинг - это обнаружение и посещение страниц, а веб-скрепинг - извлечение данных. Python делает эти два вида техники доступными даже для тех, кто не является разработчиком.

Сочетая ответственное наполнение, целенаправленное соскабливание и надежное управление для прокси-серверы для скраппинга и краулингаВы сможете создавать мощные конвейеры данных, которые будут служить основой для аналитики, моделей машинного обучения и бизнес-понятий, не прерывая работы.

Готовы к тому, чтобы повысить эффективность поиска информации в Интернете? Начните с испытание OkeyProxy Уже сегодня вы сможете обеспечить бесперебойный и масштабный сбор данных!

Высококлассный прокси-сервис Socks5/Http(s)

- Масштабируемые планы: Статический/Ротация прокси-серверов резидентов

- Бесшовная интеграция: Win/iOS/Android/Linux

- Высокая безопасность: Идеально подходит для антидетекта браузеров, эмуляторов, скреперов и т.д.

- Надежная производительность: Быстрая передача и низкая задержка