Com a explosão de dados na Internet, a necessidade de recolher, processar e analisar informações online tornou-se mais importante do que nunca. É aí que entram duas técnicas poderosasrastreio da web e raspagem da web. Embora estes termos sejam frequentemente utilizados como sinónimos, não são a mesma coisa. Quer esteja a recolher preços de produtos, a monitorizar sítios Web de concorrentes ou a criar um índice de pesquisa, estes métodos podem ajudá-lo a automatizar a recolha de dados à escala.

O mesmo? Os diferentes termos para a recolha de dados na Web

O que é o Web Crawling?

O rastreio da Web é o processo de navegação automática na Internet e de descoberta de URLs ou hiperligações em várias páginas. Pense nisto como a forma como os motores de busca como o Google encontram e indexam novas páginas Web.

🕷 Exemplo:

Um Web crawler, também conhecido como spider ou bot, parte de uma página Web e segue todas as ligações internas/externas para descobrir mais páginas. Isto permite-lhe recolher URLs, mas não necessariamente descarregar ou extrair dados específicos.

Casos de utilização típicos:

- Criar um índice de motor de pesquisa

- Monitorização das alterações do sítio Web à escala

- Detetar links quebrados no seu próprio site

O que é Web Scraping?

Raspagem da Web é o processo de extração de partes específicas de dados de uma ou mais páginas Web. Em vez de se limitarem a descobrir hiperligações, os scrapers visam conteúdos como nomes de produtos, preços ou informações de contacto e formatam-nos em CSV, JSON, etc.

🧲 Exemplo:

Poderá obter preços de produtos do Walmart ou outro sítio de comércio eletrónico, listas de empregos de um portal de carreiras, estatísticas de publicações nas redes sociais, etc.

Casos de utilização típicos:

- Ferramentas de comparação de preços

- Geração de leads (recolha de contactos de diretórios)

- Estudos de mercado (recolha de críticas, classificações)

Web Crawling Vs. Raspagem da Web: Principais diferenças

Enquanto os crawlers mapeiam a Web, os scrapers concentram-se na informação que interessa.

| Aspeto | Rastreio da Web | Raspagem da Web |

|---|---|---|

| Objetivo principal | Descobrir e indexar páginas Web | Extrair dados estruturados |

| Funcionamento | Segue as ligações recursivamente | Analisa e extrai dados específicos |

| Saída | Lista de páginas web | Dados estruturados (CSV, JSON, etc.) |

| Complexidade | Lógica por página mais simples, mas a escala é importante | Lógica de análise complexa por página |

| Ferramentas e bibliotecas | Scrapy (Crawler), Heritrix, Apache Nutch, Requests, etc. | BeautifulSoup, Selenium, lxml, Requests, etc. |

| Objetivo | Sítios Web completos | Páginas individuais ou elementos de página |

| Exemplo de utilização | Google indexa artigos de notícias | Obter títulos e autores de artigos |

Em muitos casos, ambas as técnicas são utilizadas em conjunto. Um crawler encontra páginas e um scraper extrai os dados das mesmas.

Trechos de código Python: Web Crawling Vs. Raspagem

Vejamos alguns trechos mínimos de código Python para crawling e scraping.

Como fazer Web Crawling em Python

Python facilita o rastreamento da web com bibliotecas como Sucata ou Pedidos + Bela Sopa.

Exemplo: Rastreador Web simples usando Scrapy

# instalar: pip instalar scrapy

importar scrapy

classe SimpleCrawler(scrapy.Spider):

name = "simple_crawler"

start_urls = ["https://example.com"]

def parse(self, response):

# Imprimir o título da página

title = response.css('title::text').get()

yield {'url': response.url, 'title': title}

# Seguir todas as ligações internas

for href in response.css('a::attr(href)').getall():

if href.startswith('/'):

yield response.follow(href, callback=self.parse)Exemplo: Rastreador Web simples usando Requests + BeautifulSoup

importar pedidos

from bs4 import BeautifulSoup

from urllib.parse import urljoin

visitado = set()

start_url = "https://example.com"

def crawl(url):

if url in visited:

return

visitado.add(url)

tentar:

response = requests.get(url)

soup = BeautifulSoup(response.text, 'html.parser')

print("Crawling:", url)

for link in soup.find_all('a', href=True):

full_url = urljoin(url, link['href'])

crawl(full_url)

exceto Exception as e:

print("Failed to crawl:", url, "Reason:", e)

rastrear(url_inicial) Nota: O rastreio rápido de grandes sítios Web pode fazer com que o seu IP seja assinalado e bloqueado. É por isso que precisa de proxies IP rotativos.

Como fazer Web Scarping em Python

O Web scraping em Python envolve a extração de dados de sítios Web utilizando scripts automatizados. Uma das bibliotecas mais populares para esta tarefa é a Bela Sopafrequentemente utilizado em combinação com Pedidos.

Por exemplo, é possível localizar tags, atributos ou classes específicos e extrair informações úteis como nomes de produtos, preços ou títulos.

Exemplo: Raspagem de títulos de produtos de uma página

importar pedidos

from bs4 import BeautifulSoup

url = "https://example.com/products"

resp = requests.get(url)

soup = BeautifulSoup(resp.text, 'html.parser')

for product in soup.select(".product"):

name = product.select_one(".name").get_text(strip=True)

preço = product.select_one(".price").get_text(strip=True)

print({"nome": nome, "preço": preço})Pode utilizar selectores ou XPath para obter dados de tabelas, listagens ou elementos HTML personalizados.

Sugestão: Embora a raspagem e o rastreio da Web sejam geralmente legais, alguns sítios Web proíbem esse comportamento nos termos de serviço ou nas suas robots.txt ficheiros. Verifique sempre quais são os caminhos permitidos ou não permitidos para o seu bot.

Permanecer desbloqueado sem proibição de IP usando proxy de IP

A execução de muitos pedidos a partir do seu endereço IP pode acionar defesas anti-bot, como CAPTCHAs, ou proibições definitivas de sítios Web. Para manter a fiabilidade e a velocidade, considere adicionar a utilização de um proxy IP, que pode alternar automaticamente entre milhões de endereços IP reais.

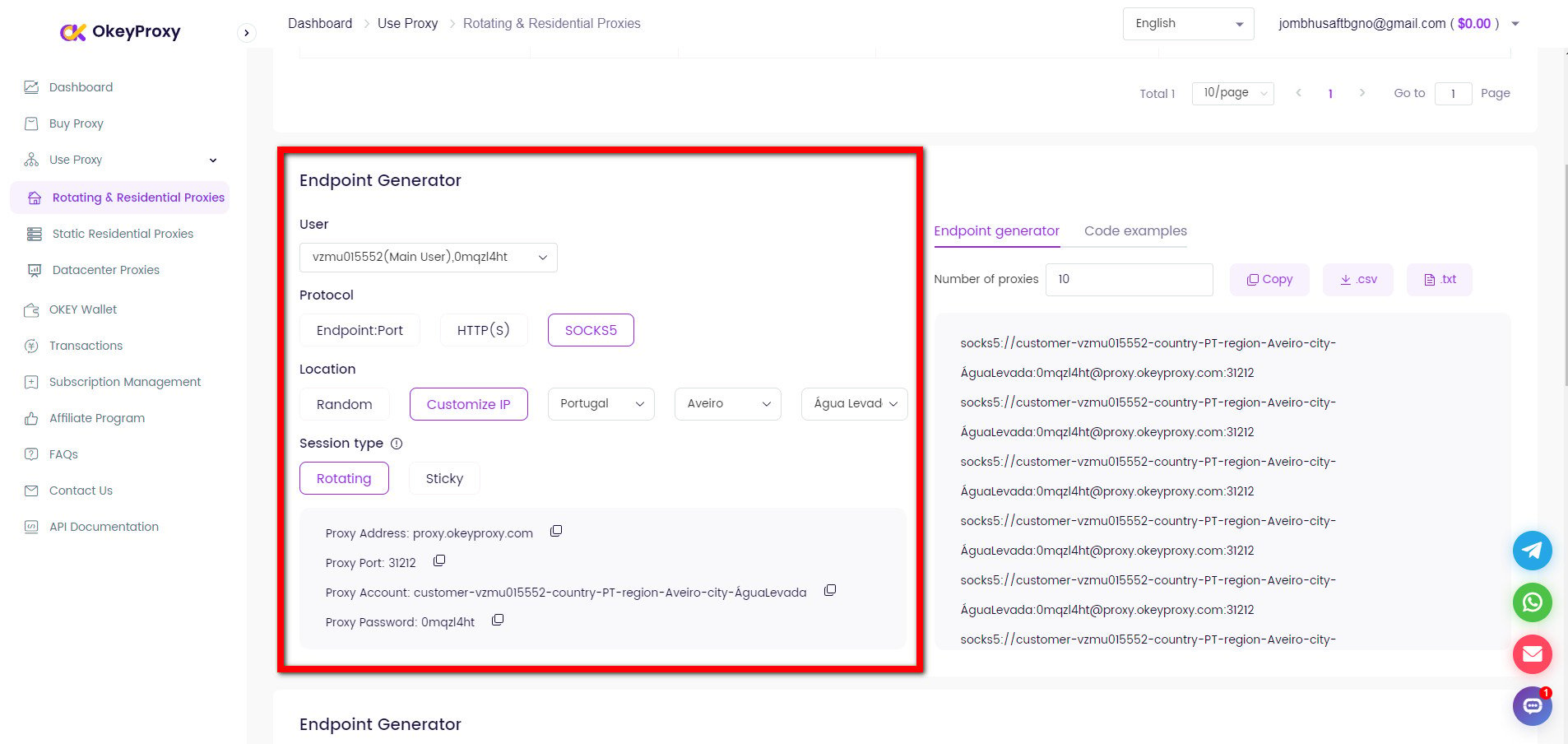

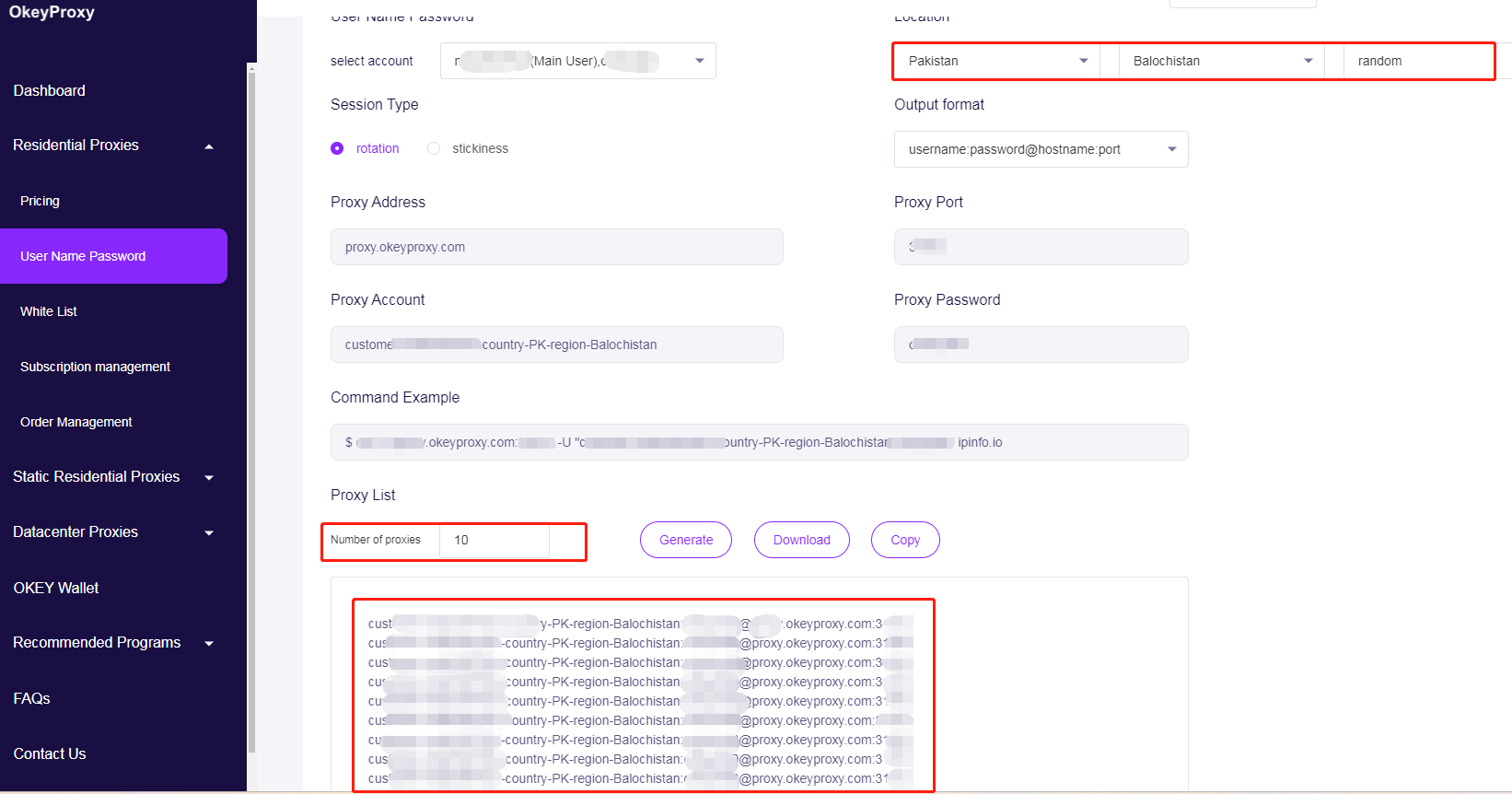

Basta configurar o seu cliente HTTP para utilizar OkeyProxy com um novo endereço IP ou com endereços IP rotativos:

Mudança para novos IPs para evitar limites de Web Crawling/Scraping

proxies = {

"http": "http://username:[email protected]:1234",

"https": "http://username:[email protected]:1234",

}

resp = requests.get(url, headers=headers, proxies=proxies, timeout=10)Rodar IPs proxy para evitar limites de rastreio/raspagem da Web

# Pool de proxy - substitua pelos seus IPs de proxy

PROXY_POOL = [

"http://username1:[email protected]:1234",

"http://username2:[email protected]:1234",

"http://username3:[email protected]:1234",

"http://username4:[email protected]:1234"

]

# Selecionar e validar aleatoriamente um proxy do conjunto

def rotate_proxy():

while True:

proxy = random.choice(PROXY_POOL)

if check_proxy(proxy):

return proxy

else:

print(f "Proxy {proxy} não está disponível, tente outro...")

PROXY_POOL.remove(proxy)

raise Exception("Não restam proxies válidos no conjunto.")

# Verificar se um proxy está a funcionar fazendo um pedido de teste

def check_proxy(proxy):

try:

test_url = "https://httpbin.org/ip"

response = requests.get(test_url, proxies={"http": proxy}, timeout=10)

return response.status_code == 200

exceto:

return FalseCom um serviço de procuração residencial de alta qualidadepode executar com segurança web crawlers ou scrapers em grande escala sem se preocupar com proibições ou rejeições.

Para que servem a pesquisa e a recolha de dados?

Amplamente utilizadas para extrair informações valiosas das vastas quantidades de dados disponíveis em linha, a pesquisa e a recolha de dados na Web tornaram-se ferramentas indispensáveis na base da atual economia dos dados.

Por um lado, as organizações utilizam a raspagem da Web para recolher opiniões de clientes, publicações em fóruns e conversas nas redes sociais para análise de sentimentos. Além da análise de sentimento do consumidor, o rastreamento de dados alimenta plataformas de inteligência de mercado, que o mercado de dados alternativos, que inclui raspagem da web, foi avaliado em US $ 4,9 bilhões em 2023 e deve crescer a um taxa anual de 28% até 2032. De facto, 42,0% dos orçamentos de dados das empresas em 2024 foram afectados especificamente à aquisição e ao processamento de dados da Web, sublinhando o seu papel fundamental na tomada de decisões com base em dados. E no sector do retalho, 59% dos retalhistas utilizam ferramentas de monitorização de preços competitivos - muitas vezes baseadas em scraping automatizado - para otimizar estratégias de preços dinâmicas e aumentar as receitas.

Por outro lado, uma das principais aplicações da recolha e da exploração de dados é a alimentação de IA e aprendizagem automática iniciativas, com 65,0% das organizações a aproveitarem a recolha de dados da Web para alimentar os seus modelos. Por exemplo, o arquivo de abril de 2024 do Common Crawl recolheu 2,7 mil milhões de páginas Web (386 TiB de conteúdo), servindo de conjunto de dados fundamental para o treino dos principais modelos de PNL. Além disso, os investigadores académicos e plataformas como a Semantic Scholar, que indexou mais de 205 milhões de artigos académicos, também utilizaram os Web crawlers para indexar vastos corpos de literatura. E as equipas de SEO e de marketing utilizam o web crawling para auditorias de sítios, análise de backlinks e pesquisa competitiva.

Conclusão

O web crawling consiste em descobrir e visitar páginas; o web scraping consiste em extrair dados. Python torna estas duas técnicas acessíveis, mesmo para quem não é programador.

Combinando rastreio responsável, raspagem orientada e gestão fiável para proxies de raspagem e rastreioCom o software de gestão de dados, pode criar pipelines de dados poderosos que alimentam a análise, os modelos de aprendizagem automática e as informações comerciais - sem interrupções.

Preparado para aumentar a sua capacidade de rastreio e raspagem da Web? Comece com um avaliação de OkeyProxy hoje mesmo e experimente uma recolha de dados em grande escala e sem falhas!

Serviço de proxy Socks5/Http(s) de alto nível

- Planos escaláveis: Estático/Rotação de mandatários residenciais

- Integração perfeita: Win/iOS/Android/Linux

- Alta segurança: Ideal para navegadores antidetectores, emuladores, scrapers, etc.

- Desempenho fiável: Transferência rápida e baixa latência