Lo scraping spesso richiede siti proxy robusti per aggirare i divieti IP, gestire richieste di dati di grandi dimensioni e mantenere l'anonimato. La selezione di fornitori di proxy di alta qualità garantisce stabilità, velocità e successo nei progetti di scraping del web. Di seguito viene fornita una guida dettagliata per la scelta di buoni siti proxy e per rispondere alle domande più comuni.

Perché i proxy sono essenziali per lo scraping del Web?

I proxy fungono da intermediari tra lo scraper di un utente e i siti web di destinazione, mascherando il vero indirizzo IP dello scraper. Ruotando tra più IP proxy, gli utenti possono evitare il rilevamento e il blocco dei loro scraper.

Caratteristiche principali di un buon sito proxy da cui effettuare lo scraping

- Pool di proxy di grandi dimensioni: Assicura un rischio minimo di divieti IP con proxy a rotazione.

- Anonimato: Protegge l'identità dell'utente nascondendo l'indirizzo IP reale.

- Tempo di risposta rapido: Fondamentale per mantenere l'efficienza della raschiatura.

- Capacità di geo-targeting: Consente l'accesso a contenuti localizzati offrendo IP di regioni specifiche.

- Supporto per i protocolli: Compatibile con i protocolli HTTP, HTTPS e SOCKS5.

Siti proxy a pagamento/liberi per lo scraping

Il principale fornitore di proxy - OkeyProxy

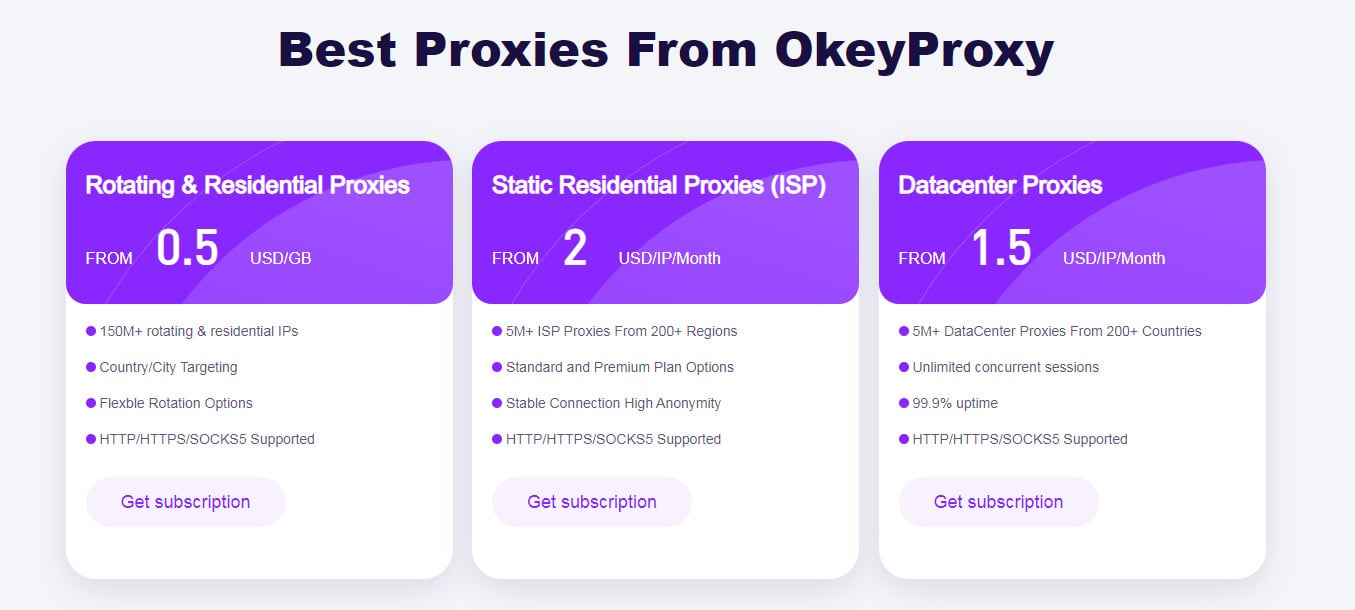

OkeyProxy è un fornitore professionale di servizi proxy noto per la fornitura di soluzioni affidabili e di alta qualità, adatte alle diverse esigenze degli utenti. Offre proxy statici residenziali e a rotazione con supporto SOCKS5 e HTTP(S), garantendo connessioni internet sicure, veloci e anonime. Progettato per applicazioni come il web scraping, il monitoraggio SEO e l'aggiramento delle restrizioni geografiche, OkeyProxy è ideale per le aziende e gli sviluppatori che desiderano operazioni online efficienti. Con un'interfaccia facile da usare e opzioni scalabili, garantisce una perfetta integrazione nei flussi di lavoro, mantenendo solidi standard di privacy dei dati.

-

Caratteristiche:

Proxy premium residenziali e per data center con rotazione automatica.

-

Casi d'uso:

Perfetto per lo scraping di siti sensibili o ad alta sicurezza che richiedono IP coerenti.

-

Pro:

Ampio pool di IP, assistenza clienti di livello superiore, connessioni convenienti e stabili, compatibilità SOCKS5 e integrazione del codice.

-

Contro:

I prezzi premium potrebbero non essere adatti ai budget più piccoli.

Proxy di scraping su piccola scala - HideMyAss

HideMyAss (HMA) Proxy gratuito è uno strumento basato sul web progettato per fornire una navigazione anonima rapida e accessibile. Permette agli utenti di aggirare le restrizioni regionali e di nascondere il proprio indirizzo IP durante l'accesso ai siti web. A differenza dei servizi VPN premium, il proxy gratuito ha caratteristiche limitate, ma offre comunque funzionalità di base come il mascheramento degli IP e la crittografia delle connessioni. È particolarmente adatto per attività occasionali come l'accesso a contenuti geo-bloccati o per mantenere un minimo di privacy online.

- Caratteristiche: Proxy basato sul Web per una navigazione rapida; IP gratuiti per la configurazione manuale.

- Pro: Facile da usare per i principianti e senza registrazione

- Contro: Velocità ridotta; non adatto per raschiare su larga scala.

Elenchi proxy per i protocolli HTTP, HTTPS e SOCKS5

ProxyScrape è una popolare piattaforma online che fornisce elenchi di proxy gratuiti e premium per attività come il web scraping, la navigazione e l'anonimato. Offre proxy HTTP, HTTPS e SOCKS, provenienti da un vasto database e aggiornati regolarmente per garantire freschezza e funzionalità. Il servizio include funzioni come il filtraggio dei proxy in base ai livelli di anonimato, alla geolocalizzazione e alla velocità, rendendolo adatto a una vasta gamma di attività online. ProxyScrape fornisce anche API per una perfetta integrazione con gli strumenti di automazione e supporta casi d'uso come il monitoraggio SEO, l'aggiramento delle restrizioni geografiche e la verifica degli annunci.

- Caratteristiche: Elenchi di proxy gratuiti con statistiche sul tempo di attività.

- Pro: Semplice filtraggio per livello di anonimato e regione.

- Contro: Le deleghe possono essere rapidamente sovrautilizzate a causa della disponibilità pubblica.

Come scegliere il miglior sito proxy per lo scraping

La scelta del miglior sito proxy per lo scraping del Web è essenziale per garantire efficienza, anonimato e accuratezza dei dati. Ecco i passaggi chiave:

-

Capire il sito web di destinazione

Analizzare le misure antiscraping, come i divieti IP o i requisiti CAPTCHA. Inoltre, selezionare i proxy in linea con la complessità del sito di destinazione.

-

Decidere il tipo di proxy

Scegliete tra proxy residenziali, per data center, statici o a rotazione in base alle vostre esigenze.

- Deleghe residenziali: I migliori per evitare il rilevamento, poiché utilizzano indirizzi IP reali degli ISP.

- Proxy per centri dati: Economico per la raschiatura di grandi volumi, ma più incline ai blocchi.

- Proxy statici o rotanti: I proxy statici sono ideali per sessioni costanti, mentre i proxy a rotazione aiutano a bypassare i limiti di velocità.

-

Valutare le dimensioni e la posizione del pool di proxy

Optate per pool più ampi con IP geo-targettizzati per ottenere risultati migliori. Un pool di proxy più ampio riduce il rischio di ripetuti divieti IP e i proxy geo-targettizzati sono essenziali per lo scraping di contenuti specifici di una regione.

-

Considerate il budget e la scalabilità

Abbinare il servizio alle dimensioni del progetto e al potenziale di crescita.

Suggerimenti per un uso efficace dei proxy nello scraping

- Ruotare i proxy: Evitare di inviare più richieste da un singolo IP.

- Attuare i ritardi nelle richieste: Ridurre i rischi di rilevamento regolando il tasso di richiesta.

- Utilizzare browser senza testa: Strumenti come Puppeteer o Selenium imitano il comportamento umano.

- Monitorare le prestazioni del proxy: Controllate regolarmente la latenza, il tempo di attività e la reputazione dell'IP.

- Testare i proxy prima della distribuzione: Effettuare test su piccola scala per garantire l'affidabilità.

Conclusione

I buoni siti proxy migliorano l'efficienza dello scraping, riducono il rischio di divieti e garantiscono un accesso continuo a dati preziosi. Fornitori come OkeyProxy offrono caratteristiche eccellenti, adatte allo scraping. La comprensione dei tipi di proxy e delle migliori pratiche ottimizzerà i progetti di scraping del Web.

Per ulteriori approfondimenti su argomenti legati alla prossimità, non esitate a esplorare altre risorse!

-